зачем запрещать индексацию сайта

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

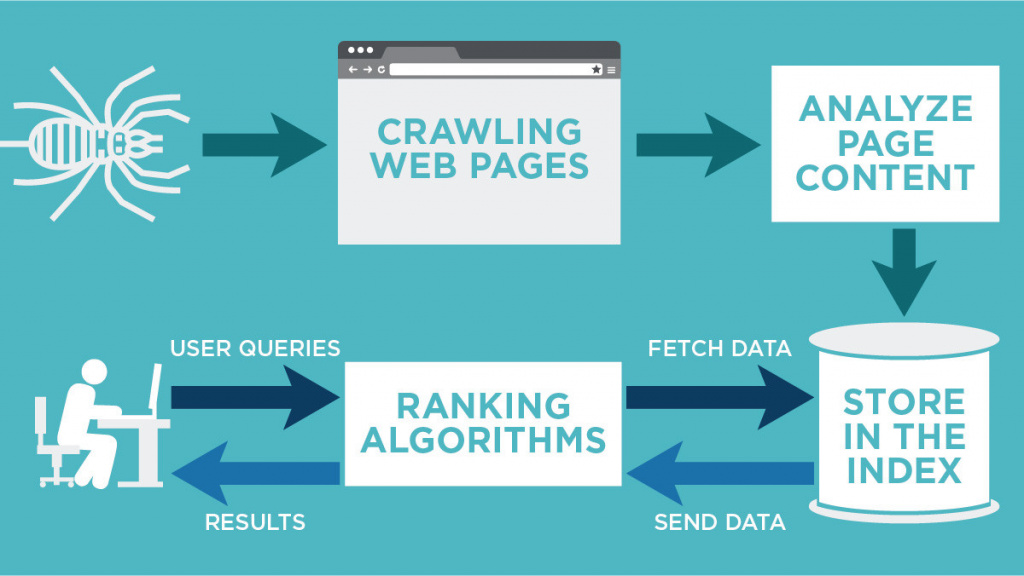

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

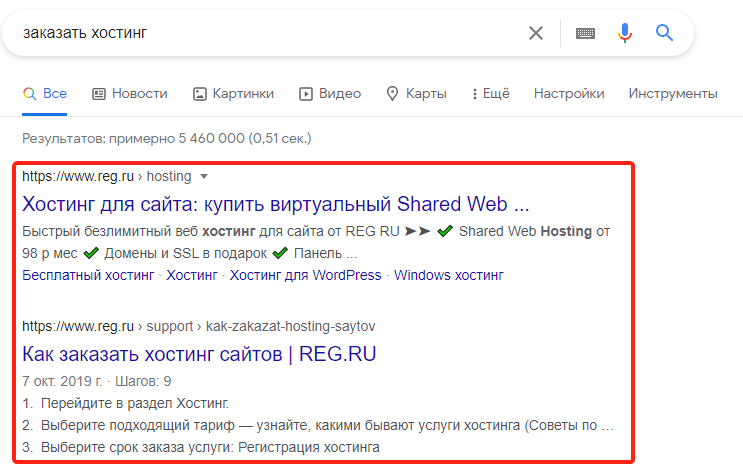

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

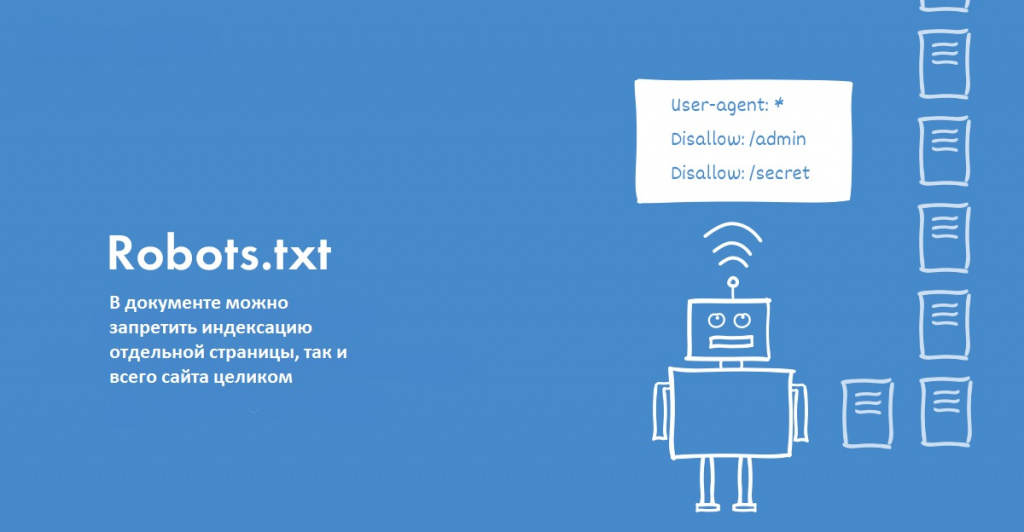

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Индексация сайта

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

Для ускорения индексации рекомендуется выполнить следующие действия:

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

Как закрыть сайт от индексации

Поделиться этим постом

Закрывать сайт от индексации нужно, например, при проведении технических работ. Это можно сделать несколькими способами: через robots.txt, метатег robots или заголовок X-Robots-Tag. Вебмастера иногда сталкиваются с ситуацией, когда запрет не срабатывает, и страницы сайта все равно индексируются поисковиками. В посте расскажем о том, как запретить индексацию сайта и убедиться в корректности этого запрета.

1. Зачем закрывать сайт или страницу от индексации

После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть сайт от поисковиков. В каких ещё ситуациях нужен запрет на индексацию:

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

2. Как закрыть сайт от индексации

Я уже упомянула, что полностью запретить индексацию сайта можно тремя способами. Теперь предлагаю рассмотреть каждый из них отдельно.

2.1. Robots.txt

Файл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

Для обращения к конкретному роботу вместо «*» используйте его название. Например, если нужно закрыть сайт от Яндекс, впишите в robots.txt:

Если требуется закрыть от индексации всеми роботами определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву. Пример:

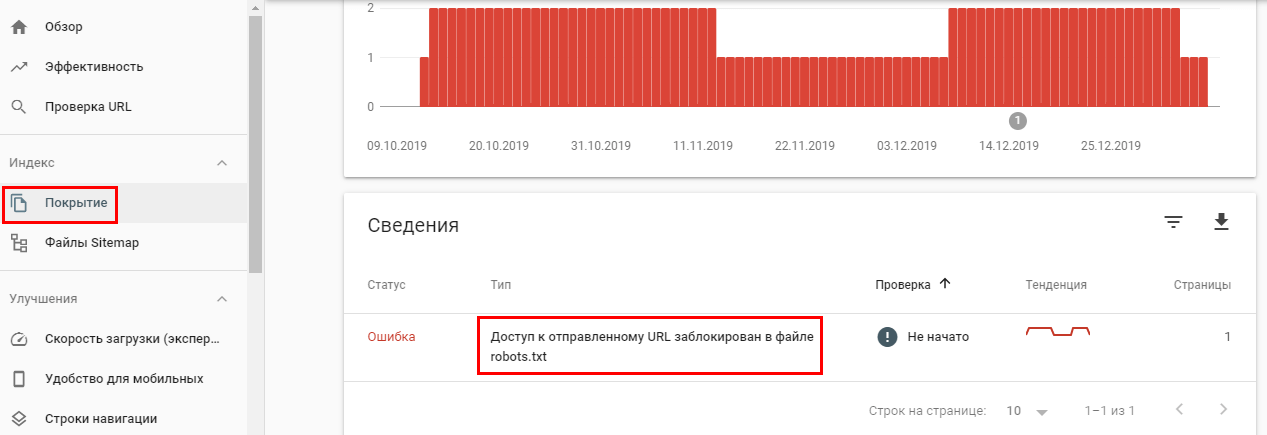

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

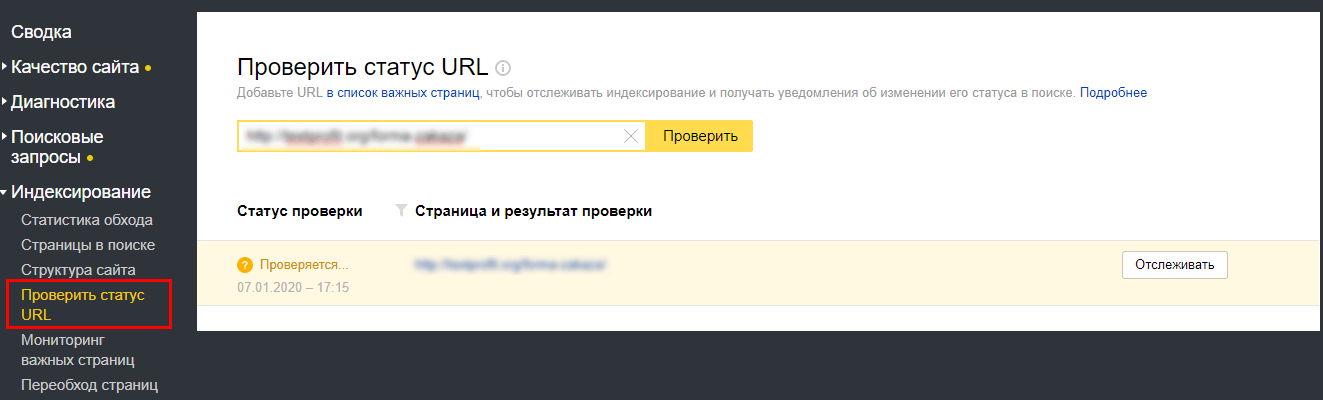

Для проверки в Яндекс.Вебмастер перейдите в раздел «Индексирование».

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, используйте следующий метод.

2.2. Метатег Robots

Этим способом можно предотвратить сканирование роботами контента. С его помощью можно также закрыть текст от индексации. Это необходимо, когда страницу нужно проиндексировать за исключением отрывка текста. Для этого добавьте в раздел страницы строку кода:

Чтобы скрыть ссылку от поисковиков, используйте nofollow:

Если и этот вариант не помогает, используйте метод серверного заголовка, описанный в следующем пункте.

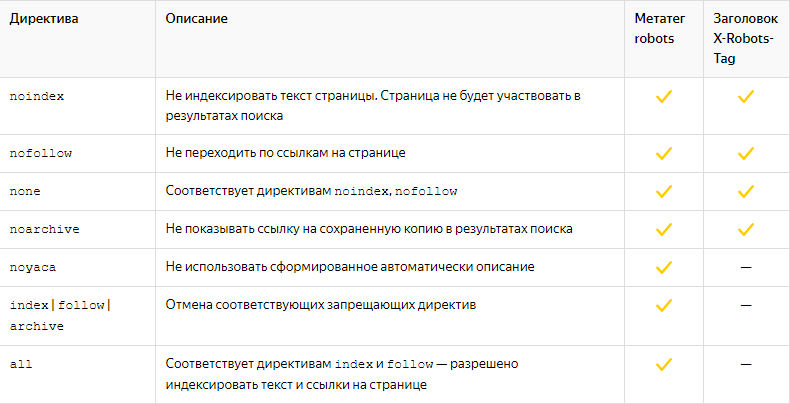

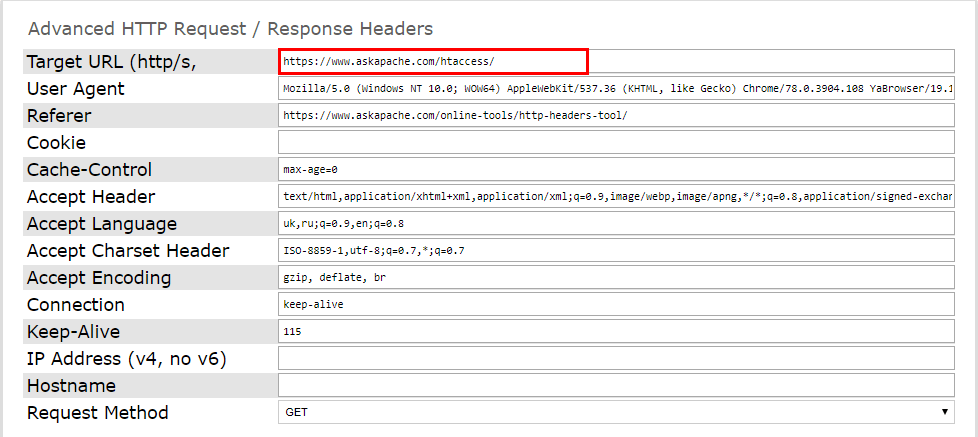

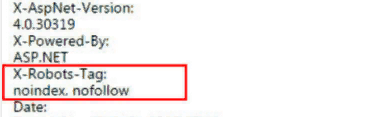

2.3. X-Robots-Tag

С помощью X-Robots-Tag можно закрыть от индексации медиа-контент, скрипты и другие файлы. Для этого нужно указать их формат после директивы FilesMatch в первой строке заголовка.

Большинство директив, которые можно использовать в X-Robots-Tag, совпадают с директивами Robots.

И проверьте работоспособность серверного заголовка. Это можно сделать при помощи онлайн-инструментов. Например, Askapache. Введите нужную страницу и запустите проверку.

Подключённый заголовок выглядит так:

Проверить код ответа сервера можно и через Яндекс.Вебмастер. Активный X-Robots-Tag отобразится в списке всех заголовков ответа сервера.

Когда и как нужно закрывать сайт от индексации

Индексация сайта поисковыми роботами — процесс сканирования и обработки данных этого сайта и добавления его в специальную базу для последующего ранжирования в выдаче. Именно благодаря индексации сайты попадают в поле видимости потенциальных клиентов. Однако иногда сайты или их отдельные страницы нужно закрывать от индексации. В этой статье рассмотрим, в каких случаях требуется это сделать, разберем способы скрытия ресурсов от поисковых краулеров и покажем, как узнать, закрыт ли сайт от индексации или нет.

Что нужно закрывать от индексации

Важно, чтобы в поисковой выдаче были исключительно целевые страницы, соответствующие запросам пользователей. Поэтому от индексации в обязательном порядке нужно закрывать:

1. Бесполезные для посетителей страницы или контент, который не нужно индексировать. В зависимости от CMS, это могут быть:

Способы закрытия сайта от индексации

Закрыть сайт или страницы сайта от поисковых краулеров можно следующими способами:

С помощью robots.txt

Robots.txt — текстовый файл, который поисковые краулеры посещают в первую очередь. Здесь для них прописываются указания — так называемые директивы.

Этот файл должен соответствовать следующим требованиям:

В robots.txt прописываются такие директивы:

Полный запрет сайта на индексацию в robots.txt

Вы можете запретить индексировать сайт как всем роботам поисковой системы, так и отдельно взятым. Например, чтобы закрыть весь сайт от робота Яндекса, который сканирует изображения, нужно прописать в файле следующее:

Чтобы закрыть для всех роботов:

Чтобы закрыть для всех, кроме указанного:

В данном случае, как видите, индексация доступна для роботов Яндекса.

Запрет на индексацию отдельных страниц и разделов сайта

Для запрета на индексацию одной страницы достаточно прописать ее URL-адрес (домен не указывается) в директиве файла:

Чтобы закрыть раздел или категорию:

Чтобы закрыть все, кроме указанной категории:

Чтобы закрыть все категории, кроме указанной подкатегории:

В качестве подкатегории здесь выступает «main».

Запрет на индексацию прочих данных

Чтобы скрыть директории, в файле нужно указать:

Чтобы скрыть всю директорию, за исключением указанного файла:

Чтобы скрыть UTM-метки:

Чтобы скрыть скриптовые файлы, нужно указать следующее:

По такому же принципу скрываются файлы определенного формата:

Через HTML-код

Запретить индексировать страницу можно также с помощью метатегов в блоке в HTML-коде.

Атрибут «content» здесь может содержать следующие значения:

Открывать и закрывать страницу и ее контент можно для краулеров определенной ПС. Для этого в атрибуте «name» нужно указать название робота:

Чтобы запретить индексировать страницу краулерам Google, нужно ввести:

Чтобы сделать то же самое в Яндексе:

На уровне сервера

Для краулеров Яндекса таким:

На WordPress

В процессе создания сайта на готовой CMS нужно закрывать его от индексации. Здесь мы разберем, как сделать это в популярной CMS WordPress.

Закрываем весь сайт

Закрыть весь сайт от краулеров можно в панели администратора: «Настройки» => «Чтение». Выберите пункт «Попросить поисковые системы не индексировать сайт». Далее система сама отредактирует файл robots.txt нужным образом.

Закрытие сайта от индексации через панель администратора в WordPress

Закрываем отдельные страницы с помощью плагина Yoast SEO

Чтобы закрыть от индексации как весь сайт, так и его отдельные страницы или файлы, установите плагин Yoast SEO.

Для запрета на индексацию вам нужно:

Закрытие от индексации с помощью плагина Yoast SEO

Настройка режима индексации

Запретить индексацию сайта на WordPress можно также через файл robots.txt. Отметим, что в этом случае требуется особый подход к редактированию данного файла, так как необходимо закрыть различные служебные элементы: страницы рассылок, панели администратора, шаблоны и т.д. Если этого не сделать, в поисковой выдаче могут появиться нежелательные материалы, что негативно скажется на ранжировании всего сайта.

Как узнать, закрыт ли сайт от индексации

В Яндекс.Вебмастере

Для проверки вам нужно пройти верификацию в Яндексе, зайти в Вебмастер, в правом верхнем углу найти кнопку «Инструменты», нажать и выбрать «Проверка ответа сервера».

Проверка возможности индексации страницы в Яндекс.Вебмастере

В специальное поле на открывшейся странице вставляем URL интересующей страницы. Если страница закрыта от индексации, то появится соответствующее уведомление.

Так выглядит уведомление о запрете на индексацию страницы

Таким образом можно проверить корректность работы файла robots.txt или плагина для CMS.

В Google Search Console

Проверка возможности индексации в Google Search Console

С помощью поискового оператора

Введите в поисковую строку следующее: site:https:// + URL интересующего сайта/страницы. В результатах вы увидите количество проиндексированных страниц и так поймете, индексируется ли сайт поисковой системой или нет.

Проверка индексации сайта в Яндексе с помощью специального оператора

Проверка индексации отдельной страницы

С помощью такого же оператора проверить индексацию можно и в Google.

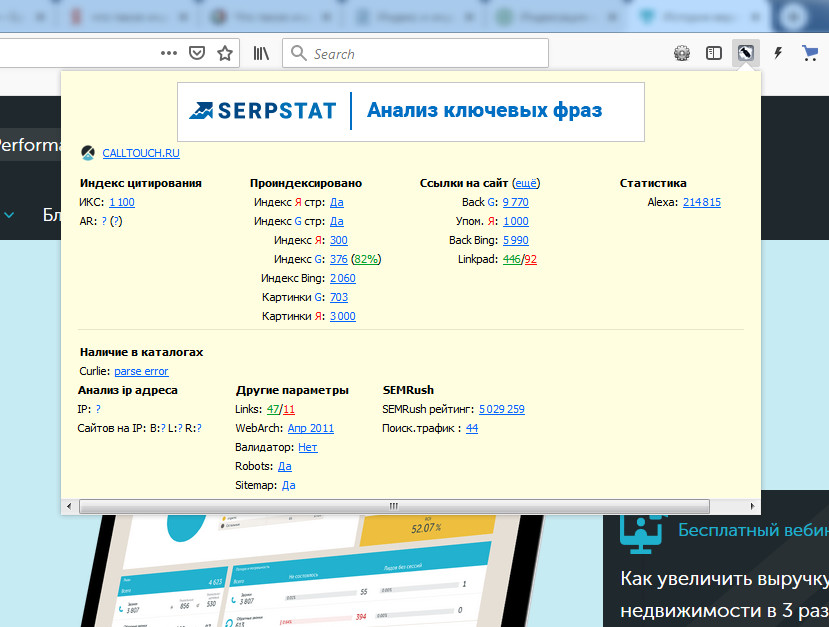

С помощью плагинов для браузера

Мы рекомендуем использовать RDS Bar. Он позволяет увидеть множество SEO-показателей сайта, в том числе статус индексации страницы в основных поисковых системах.

Плагин RDS Bar

Итак, теперь вы знаете, когда сайт или его отдельные страницы/элементы нужно закрывать от индексации, как именно это можно сделать и как проводить проверку, и можете смело применять новые знания на практике.

Сайт закрыт от индексации: это не повод для паники

Из этой статьи вы узнаете:

Согласитесь, сегодняшняя тема довольна необычна. Если вы – начинающий интернет-предприниматель, то больше всего вас интересует трафик на ваш сайт и появление его страниц в поисковиках. Почему же иногда сайты специально закрывают от индексации? Попробуем объяснить, что значит – сайт закрыт от индексации.

Сайт закрыт от индексации – что это значит

Поисковая индексация сайта – это процесс занесения страниц в базу данных поисковых систем. То есть именно благодаря индексации поисковая система узнает о вашем ресурсе, его содержимом и о том, насколько сайт ценен для пользователей.

На страницы сайта заходит поисковой робот (виртуальная программа) и считывает размещенную на них информацию. После этого она подлежит занесению в базы данных поисковиков и ранжированию.

Есть два способа, с помощью которых поисковой робот узнает о новом веб-ресурсе: через ссылку, размещенную на одном из известных сайтов, либо в случае самостоятельного добавления веб-мастером своего сайта в индексацию.

Рекомендуемые статьи по данной теме:

Посещения робота являются периодическими, в связи с этим актуальность индексации сайта всегда высокая. То есть о внесении изменений на страницы вашего сайта или добавлении новых страниц робот быстро узнает, и информация будет учтена.

Для обеспечения успешного прохождения поисковой индексации и ее высокого качества необходимо соблюдение следующих требований:

По какой причине может быть сайт закрыт от индексации?

Например, вы только приступаете к разработке сайта, внося изменения в него напрямую. На этом этапе ресурс и его содержимое не такие, какими их предполагается преподнести в итоге пользователям. Поэтому разумно закрыть страницы сайта от индексации в Google и Яндекс до окончания работ над ним.

Что именно на сайте необходимо закрывать от индексации

Сайт будет проиндексирован, а страницы ранжированы хорошо, если поисковая система обойдет ключевые страницы сайта, нуждающиеся в продвижении, и при этом сумеет точно определить, какой контент является основным.

Сайты, которые нам приходится анализировать, имеют ошибки двух типов:

Рассмотрим, что на самом деле не должны видеть поисковые роботы, и как лучше прятать информацию:

Контент

Оценка страниц поисковыми роботами является комплексной и для нее используются не только текстовые показатели. Закрывая различные блоки, можно спрятать сведения, которые, наоборот, помогают оценивать и ранжировать страницы.

Какие ошибки наиболее распространены:

С какой целью часть содержимого сайта закрывают?

Однако эти цели вполне достижимы и без закрытия части контента!

Выходом будет выведение на страницах лишь непосредственно относящихся к разделу пунктов.

Тогда в основном коде нужно выводить только популярные, а остальные загружать только по требованию посетителя нажатием кнопки «показать все». Да, предполагается использование скриптов, но ведь вы не обманываете пользователя. Поисковый робот сможет увидеть все пункты, однако значение их будет оценено не так, как основных.

Выкладывайте меньше новостей, либо публикуйте только заголовки, либо вовсе избавьтесь от этого блока, если пользователи им не интересуются или на странице мало основного контента.

Поисковики не идеальны, однако становятся все более совершенными. В настоящее время Google, если обнаруживает скрытые от индексации скрипты, выдает ошибку в панели Google Search Console (вкладка «Заблокированные ресурсы»).

Закрывать доступ роботам к части содержимого сайта иногда полезно, но это не позволит оптимизировать сайт. Использовать такой способ можно лишь в случае крайней необходимости.

Что можно посоветовать:

Рассмотрим используемые для скрытия содержимого сайтов методы:

Noindex

Имеет ряд недостатков. Во-первых, с помощью этого тега можно скрыть контент только от Яндекса, а закрыть доступ к тексту Google невозможно.

Кроме того, возможен запрет на индексацию и включение в выдачу поисковика только текстовых данных. Применительно к другим данным (например, ссылкам) он не действует. Это видно из описания тега в справке Яндекса.

Техподдержка Яндекса не раскрывает, как работает noindex. Немного больше можно об этом узнать из обсуждения в официальном блоге.

Когда целесообразно использовать тег:

Метод отличается универсальностью. Применяется для скрытия информации и от Яндекса, и от Google. Это лучший способ чистки сайта от размывающего релевантность контента. Поисковые системы такой метод не одобряют. Для них желательно, чтобы поисковые роботы имели доступ к тому же контенту, что и посетители.

Очень многие используют технологию AJAX. Если не заниматься откровенным клоакингом, то санкций за это можно избежать. Минусом метода является необходимость закрытия доступа к скриптам, хотя поисковики не рекомендуют этого делать.

Страницы сайта

Какие страницы следует прятать:

Какие есть способы закрытия страниц от индексации:

Метод не очень хорош. Во-первых, файл robots не может бороться с дублями и чистить сайты от мусорных страниц. Во-вторых, robots закрыть сайт от индексации позволяет не всегда.

Noindex

Использование этого метатега делает возможным гарантированное исключение страниц из индекса.

Синтаксис у Яндекса и Google различен.

Вот метатег, который понимают оба поисковика:

Googlebot будет видеть метатег noindex, если доступ к страницам, закрытым в файле robots.txt, будет закрыт. В противном случае бот, возможно, даже не посетит эти страницы.

Защита с помощью пароля

Этот способ следует применять для скрытия конфиденциальных данных. Google выделяет его как отличающийся надежностью.

Если надо закрыть доступ ко всему сайту (к примеру, к тестовой версии), то этот метод подойдет как нельзя лучше. Но и он несовершенен – вы можете столкнуться с трудностями, если понадобится просканировать запароленный домен.

Это метод не просто для исключения из индекса страниц, которые генерируются фильтрами, сортировкой и т.д., а для исключения возможности их создания.

К примеру, если посетитель выбрал в фильтре нужные параметры, под которые нет отдельной страницы, то при изменении отображаемых на странице товаров непосредственно URL изменяться не будет.

Этот способ непростой, поскольку невозможно его применение одновременно для всех случаев. Часть формируемых страниц используется для продвижения.

К примеру, страницы, генерируемые фильтрами. Для «холодильник + Samsung + белый» страница необходима, а для «холодильник + Samsung + белый + двухкамерный + no frost» – уже нет. В связи с этим нужен инструмент для создания исключений. Это делает работу программистов более сложной.

Методы запрета индексации от поисковых алгоритмов

С помощью этого инструмента можно установить способ идентификации появления в URL страниц новых параметров.

Для прописывания аналогичного запрета для параметров URL в Яндексе используется директива Clean-param.

Инструменты точечного удаления страниц

При необходимости срочного удаления данных из индекса и невозможности ждать, пока запрет увидят поисковые роботы, применяют инструменты из панели Яндекс Вебмастер и Google Search Console.

В Яндексе это «Удалить URL»:

Внутренние ссылки

Запрет на индексирование внутренних ссылок делают с целью перераспределить внутренний вес на ключевые продвигаемые страницы. Однако нужно помнить:

Какими способами можно скрывать ссылки:

Noindex

Этот тег можно использовать только для запрета доступа к текстовому контенту. Ссылки с помощью него не скрыть.

Атрибут rel=”nofollow”

В настоящее время с его помощью невозможно сохранение веса на странице. Использование rel=”nofollow” ведет к потере веса, поэтому использовать этот тег для внутренних ссылок нелогично. Googlе не рекомендует обращаться к этому инструменту.

Скрипты

Этот метод действительно позволяет прятать ссылки от поисковиков. Возможно использование Аjax и подгрузки блоков ссылок уже после загрузки страницы либо добавление ссылок с подменой тега на скриптом, однако помните, что поисковым алгоритмам под силу распознавание скриптов.

Аналогично ситуации с контентом – это «костыль», прибегать к помощи которого стоит не всегда. Если нет уверенности в целесообразности скрытия блока ссылок, то откажитесь от использования подобных методов.

Вас также может заинтересовать: Повышение конверсии сайта

Как полностью закрыть сайт на WordPress от индексации

Способ 1. Через встроенную функцию в WordPress

Удаление ресурса из поисковиков – процесс несложный. Осуществляется он с помощью встроенной функции в WordPress «закрыть сайт от индексации» и сканирования. Для этого:

Способ 2. Закрыть сайт от индексации через robots.txt

Если вам больше по душе делать все вручную, то можно самим заняться редактированием данного файла. Результат будет аналогичен. С помощью файла Роботс закрыть сайт от индексации нетрудно:

Первый код позволяет предотвратить как сканирование, так и индексацию вашего ресурса. Этот код в файле robots.txt – сигнал для поисковиков о том, что сканировать сайт запрещено.

Способ 3. Защита сайта паролем с помощью контрольной панели вашего хостинга

Поисковикам и поисковым роботам доступ к файлам, которые защищены паролем, закрыт. Существуют следующие способы защиты файлов паролем:

Если вы – клиент Hostinger, то для включения функции защиты паролем вам нужно использовать инструмент, который называется «Защита Папок Паролем».

Процесс будет аналогичным и в случае использования cPanel. Потребуется:

Способ 4. Запаролить сайт, используя плагин

Получить аналогичный результат можно, установив плагины. Есть много плагинов, которые можно использовать в таких целях. Стоит выделить следующие: Password Protected Plugin, WordFence. Ваша задача – выбрать наиболее свежий и установить его.

После установки нужно будет зайти в настройки плагина и установить пароль для сайта. После того как вы защитите ваш ресурс паролем, доступ поисковикам к нему закроется. Соответственно, индексация ими сайта станет невозможной.

Вас также может заинтересовать: Инструменты аналитики сайта

Как закрыть сайт от индексации на Opencart

Защитить от индексации поисковых систем сайт на Opencart невозможно, просто выключив в админке самого интернет-магазина! Посещение вашего закрытого сайте поисковыми роботами продолжится. Они будут тащить его в индекс, что негативно скажется на продвижении.

Хороший выход – закрыть доступ к сайту, отредактировав файл robots.txt. Понадобится удалить все, оставив только пару строк из всего содержимого этого файла.

Как запретить индексирование поисковыми роботами веб-ресурса:

Как в Битрикс закрыть сайт от индексации

Кроме того, возможно отключение индексации всех страниц с подключенным компонентом sotbit:seo.meta. Для этого нужно зайти в общие настройки модуля SEO умного фильтра и включить опцию «Отключить индексацию всех страниц».

Приоритетными будут настройки индексации в условии, а не эта опция. То есть в случае отключения в настройках условия опции «Закрыть от индексации» страница, удовлетворяющая этому условию, будет проиндексирована.

Как закрыть на сайте от индексации папки, файлы, картинки и поддомен

Закрыть от индексации отдельную папку

Если папка отдельная, то можно закрыть к ней доступ поисковикам опять же в файле robots.txt, явно указав ее (закроется доступ ко всему содержимому этой папки).

User-agent: *

Disallow: /folder/

Если папка закрыта, а какой-либо файл из нее вы желаете проиндексировать, то вам нужно применить одновременно оба правило Allow и Disallow:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Закрыть от индексации файл

User-agent: Yandex

Disallow: /folder/file.php

При необходимости закрытия файла в Google в анкете нужно указать, как он называется.

Закрыть от индексации картинки

Чтобы закрыть доступ к изображениям форматов jpg, png и gif, используйте следующие команды:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Закрыть от индексации поддомен

В основном, каждый поддомен веб-ресурса имеет свой файл robots.txt. Как правило, его местонахождением является папка, корневая для поддомена. Необходима корректировка содержимого файла: нужно указать разделы, которые хотите закрыть, используя для этого директорию Disallow. Если файла нет, нужно создать его.

2 варианта, как проверить закрыт сайт от индексации или нет

Вариант №1. С помощью расширения

Если вы пользуетесь браузером Сhrome, то установите расширение NoFollow Simple. Если же вы используете другой браузер, то понадобится установка именно Сhrome.

После установки нужно открыть его и кликнуть на значок в верхнем правом углу левой клавишей мышки. В раскрывшемся списке инструментов выбрать Расширения.

Снизу этой страницы ищем Еще расширения, кликаем на них. Открывается страница интернет-магазина Сhrome. Не пугайтесь, там есть и бесплатные вещи. Смело вбивайте в поиск «Сhrome расширение NoFollow Simple», скачивайте и включайте его.

В дальнейшем благодаря этому расширению, загружая любой сайт, вы будете видеть такое изображение:

В красной рамке будут ссылки, индексация которых поисковыми роботами не была проведена.

Как видите, ничего сложного!

Вариант №2. С помощью кода страницы

Если вы хотите избежать установок, а индексацию ссылки знать нужно, вам подойдет следующий вариант. Ссылку для определенной страницы любого сайта из любого браузера можно проверить с помощью кода страницы.

Переходите на эту страницу, кликнув правой клавишей мышки, выбирайте Просмотр кода страницы или Исходный код (это зависит от браузера).

Когда страница откроется, нужно нажать F3 и ввести в открывшееся окошко нужную ссылку. Как в примере ниже.

Она выделилась оранжевым цветом. Перед ней стоит параметр rel=”nofollow”. Это говорит о том, что ссылка недоступна для индексирования. Если вам нужна ссылка, прошедшая индексацию, этого параметра быть не должно.