что такое lfc в мониторе

AMD опубликовала таблицу всех мониторов FreeSync с диапазоном FreeSync и поддержкой LFC

Ситуация с поддержкой технологии FreeSync начинает налаживаться: проникновение технологии на рынке можно назвать широким, да и со стороны пользователей интерес растет. С другой стороны, обилие разных типов панелей, разрешений и портов вносят путаницу. Как выбрать правильный монитор с поддержкой FreeSync? AMD решила облегчить задачу пользователям и опубликовала на своем сайте полный список мониторов с поддержкой FreeSync.

Удобно то, что AMD добавила некоторые важные детали. Среди них – диапазон, в котором работает поддержка FreeSync. Он зависит от используемой панели и отличается от одного монитора к другому. Нижняя планка составляет 30 Гц, у самой быстрой панели верхний порог – 144 Гц. Но монитора с диапазоном FreeSync 30-144 Гц пока не представлено.

Также в новом списке приводятся все мониторы, которые поддерживают Low Framerate Compensation. Поддержка LFC является важной функцией, решающей некоторые проблемы FreeSync. Если частота кадров опустится ниже минимальной поддерживаемой планки дисплеев FreeSync, поток кадров прервется, что пользователь воспримет как небольшое подергивание или рывок. А технология FreeSync как раз призвана предотвращать подобные артефакты. Алгоритм определяет, когда частота кадров падает ниже минимальной частоты обновления дисплея, и поддерживает ее выше данного порога. Если видеокарта не успевает подать новый кадр, монитор просто повторяет предыдущий кадр.

Условием для функционирования Low Framerate Compensation является поддержка монитором максимальной частоты FreeSync в 2,5 раза или выше минимальной частоты FreeSync. В случае, например, ASUS MG279Q диапазон FreeSync составляет 35-90 Гц. Это как раз соответствует разница в 2,5 раза. Поскольку не все мониторы FreeSync соответствуют данному условию, при покупке следует обращать внимание на диапазон частот FreeSync. Какой-либо маркировки поддержки LFC не предусмотрено. Хотя, конечно, производителям мониторов следует предоставлять всю необходимую информацию покупателям. Подробности вы можете прочитать в нашей статье о драйверах Radeon Software Crimson Edition.

В любом случае, если вы собираетесь покупать монитор FreeSync, проверьте его характеристики в таблице AMD.

Новые дисплейные технологии AMD Radeon Technologies Group

Введение

Мы уже писали о том, что в сентябре нынешнего года компания AMD объявила о реорганизации и создании выделенного подразделения Radeon Technologies Group (RTG), которое сфокусировано на графических решениях, а также сегментах виртуальной и дополненной реальности. Во главе этой группы стоит Раджа Кодури (Raja Koduri) — вице-президент и главный графический инженер компании.

Идея выделения «графической группы» в отдельное подразделение AMD должна способствовать оптимизации внутренних процессов компании и акценте RTG на графических решениях, дела с которыми у компании в последнее время идут хоть и не идеально, но явно лучше, чем у процессорного подразделения.

Мы ждали какой-то активности и анонсов от нового подразделения компании, занимающегося вопросами разработки графических процессоров, и вот, 8 декабря они анонсировали несколько новых технологий и улучшений, связанных с выводом изображения на экран. Хотя ничего эксклюзивного и уникального пока что не было представлено, но многие дисплейные технологии компании получили важные и полезные улучшения.

К примеру, была объявлена поддержка планируемых к выходу дисплеев, предназначенных для вывода HDR-изображений, анонсированы некоторые нововведения в технологии динамической частоты обновления FreeSync, также было объявлено и о поддержке разъемов HDMI 2.0a и DisplayPort 1.3 следующим поколением графических процессоров компании AMD.

Поддержка HDR-дисплеев с расширенным динамическим диапазоном

Потребители нуждаются во все более качественном выводе изображения, и для его обеспечения уже сейчас используется довольно большое количество пикселей, особенно если речь идет об устройствах виртуальной реальности и 4K-дисплеях. Но для получения по-настоящему качественной картинки нужно не только большое количество пикселей, но и повышение их качества: вывод изображений в широком цветовом охвате с увеличенной контрастностью и максимальной яркостью.

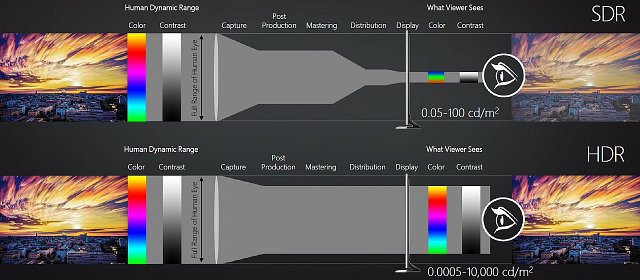

На современных дисплеях человек видит лишь малую часть того, что он может наблюдать своими глазами в окружающем мире. Иначе говоря, диапазон воспринимаемых нашим глазом яркостей и цветов куда больше того, что дают нам нынешние устройства вывода визуальной информации. Возьмем, к примеру, относительную яркость (интенсивность свечения), которая измеряется в канделах на м² (также единица измерения известна как нит, 1 нт = 1 кд/м²).

Для солнечного света этот показатель равен 1 600 000 000 нт, яркие блики на изображениях могут иметь яркость в десятки и сотни тысяч нит, зато детали в тенях — менее 1 нт. Этот диапазон очень широк, хотя относительная яркость для большинства привычных объектов составляет от 1 до 250 нт, и современные мониторы способны как раз отобразить от 0,1 нт до 250 нт максимум, а лучшие из обычных телевизоров — до 400 нт.

Для того чтобы хоть немного приблизиться к возможностям человеческого зрения, был введен новый индустриальный стандарт для телевизоров — HDR UHDTV, обеспечивающий диапазон яркости от 0,005 до 10 000 нт. Внедрение High Dynamic Range во все стадии конвейера обработки изображения — то, чего ждут многие энтузиасты качественного изображения.

Первые HDR-устройства имеют яркость до 600-1200 кд/м², а в будущем ЖК-мониторы с поддержкой High Dynamic Range (HDR) и локальной подсветкой смогут обеспечить до 2000 нт, а OLED-дисплеи — до 1000 нт максимум, но при идеальном черном цвете и большей контрастности, чем ЖК-дисплеи.

Первые подобные HDR-дисплеи ожидаются во второй половине 2016 года, ближе к его концу, а некоторые телевизоры с расширенным диапазоном уже доступны на рынке. Пусть они пока и далеки от идеальных показателей, но OLED обеспечит черный цвет, а LCD с локальной подсветкой способны на огромную яркость, и оба типа экранов подходят в том числе для игр, обеспечивая лучшие показатели по яркости, контрастности и цвету, приближающиеся к возможностям нашего зрения.

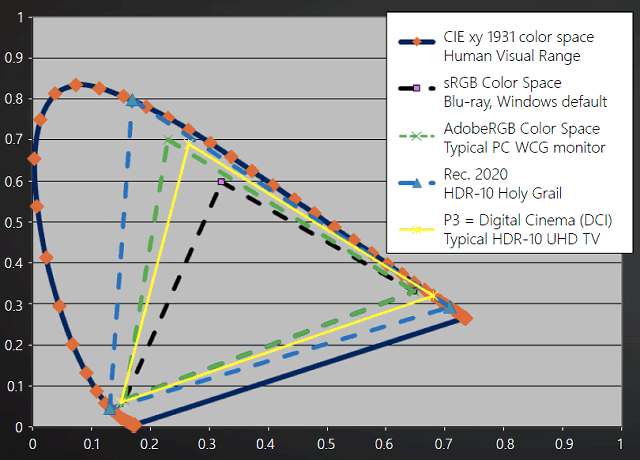

К слову о цвете: также пользователям нужен и расширенный цветовой диапазон, ведь наиболее распространенное сейчас цветовое пространство sRGB тоже довольно сильно отстает от возможностей зрения человека. И даже расширенное цветовое пространство AdobeRGB не дает всех возможных цветовых оттенков, как и стандарт, принятый для цифровых кинофильмов — P3.

Нынешний контент почти весь создан в рамках стандартов BT.709, sRGB, SMPTE 1886 (Gamma 2.4), а новый стандарт HDR-10, Rec.2020 (BT.2020), SMPTE 2084 способен обеспечить отображение более миллиарда цветов при 10 битах на компонент цвета, что весьма серьезно приближает качество цветопередачи к возможностям человеческого организма по распознаванию цветовых оттенков.

Для обеспечения высокого качества изображения нужны также и новые методы кодирования цветов, поскольку текущие методы были спроектированы в соответствии с устаревшими рекомендациями прошлого века с учетом исключительно ЭЛТ-устройств: они предполагают максимальную светимость в 100 нт, нерационально расходуют информацию в кодированном сигнале и плохо сохраняют данные в тенях.

Для современного контента разработаны новые стандарты: 10-битный и 12-битный ST 2084. Они учитывают возможности современных ЖК-дисплеев, могут закодировать световую интенсивность от 0 до 10 000 нт, значительно улучшают качество и эффективность кодирования данных в тенях, а 12-битный вариант и вовсе превосходит возможности человеческого зрения.

Но не нужно путать обсуждаемую тему HDR-возможностей устройств отображения с тем, что давно появилось в играх и называется HDR-рендерингом. Действительно, многие современные игровые движки используют рендеринг с расширенным динамическим диапазоном, чтобы сохранить данные в тенях и светах — но делается это исключительно до вывода информации на дисплей. А далее изображение в любом случае будет приводиться обратно к обычному динамическому диапазону, чтобы можно было вывести его на SDR-монитор.

Для того чтобы сохранить максимум цветов и светимости, используются специальные алгоритмы тонального отображения (tone mapping) — преобразования тональных значений из широкого диапазона в узкий. И с учетом новых HDR-устройств нужны как улучшенные алгоритмы tone mapping, так и ориентация их уже на HDR-, а не на SDR-дисплеи. Инженеры AMD как раз и предлагают более эффективный и высокопроизводительный алгоритм tone mapping, предназначенный для видеокарт серии Radeon.

В результате работы нового алгоритма при подключении HDR-дисплея вместо тусклых цветов и малого диапазона яркостей на монитор будет выведено куда более яркое и близкое к реальности изображение. Мы уже видели HDR-рендеринг с выводом на HDR-телевизор в работе, и его результат выглядит весьма впечатляюще, особенно при сравнении с изображением на обычным мониторе, стоящем рядом. Так что стандартизацию и появление HDR-телевизоров и мониторов можно назвать одной из небольших революций, которая должна произойти довольно скоро.

В данный момент компания AMD усиленно работает для того, чтобы обеспечить поддержку HDR-дисплеев в своих видеокартах серий Radeon 300 и будущих продуктах, которые появятся в 2016 году и будут готовы к появлению массовых HDR-телевизоров и мониторов в конце года.

Собственно, в определенной мере даже нынешние видеокарты Radeon уже готовы к работе с такими мониторами. Серия Radeon 300 обеспечивает работу мониторов в разрешении 1920×1080 при 120 Гц и 10 бит на цвет, в разрешении 2560×1440 при 60 Гц и 10 бит, а также в 4K-разрешении, но уже лишь при 30 Гц. Будущие же видеокарты в максимальном разрешении обеспечат частоту обновления в 60 Гц, в чем им поможет поддержка новых портов вывода: HDMI 2.0a и DisplayPort 1.3.

Сейчас AMD старается в будущем году обеспечить поддержку HDR-дисплеев рабочими станциями и игровыми ПК, ведь те же кинофильмы уже могут получить преимущество от такого вывода, так как Голливуд давно использует стандарты, превышающие бытовые. А вот для того, чтобы получить HDR-изображение в тех же игровых приложениях, будет необходимо переделывать не только графическую часть игрового движка, но и часть контента: например, текстуры должны также храниться в форматах, позволяющих использовать широкий цветовой и яркостный охват. Так что компания AMD работает с игровыми разработчиками для того, чтобы лучшие игры 2016 года уже могли полноценно использовать возможности HDR-дисплеев.

И еще один важный момент, на который нужно будет обратить внимание при использовании грядущих HDR-телевизоров в качестве мониторов для ПК: сочетание вывода отрисованного 3D-изображения в широком динамическом диапазоне и его дальнейшей постобработки в телевизоре, которая зачастую просто не отключается полностью в большинстве телевизоров. Было бы неплохо, если производители HDR-телевизоров обратили на это внимание и дали возможность полного отключения всей постобработки, попросту вредной при работе в качестве ПК-монитора.

Улучшения технологии AMD FreeSync

Группа Radeon Technologies Group не могла обойти своим вниманием и технологию динамической частоты обновления AMD FreeSync, имеющей несколько преимуществ перед аналогичной возможностью конкурента — Nvidia G-Sync. Главным плюсом технологии AMD можно считать отсутствие необходимости в установке специальной платы в мониторы и оплаты лицензионных взносов со стороны производителей дисплеев. Соответственно, сравнимые по параметрам устройства с поддержкой FreeSync стоят обычно меньше, чем G-Sync-мониторы.

Неудивительно, что количество производителей дисплеев с поддержкой FreeSync более чем вдвое выше, чем с G-Sync, да и разнообразие моделей мониторов с поддержкой этих технологий примерно аналогичное, и снова в пользу FreeSync. Кроме этого, большая доля FreeSync-мониторов имеет на борту не только разъемы DisplayPort, но и HDMI, а весьма приличная часть таких мониторов основана на качественных IPS- и *VA-матрицах и/или имеет высокое 4K-разрешение.

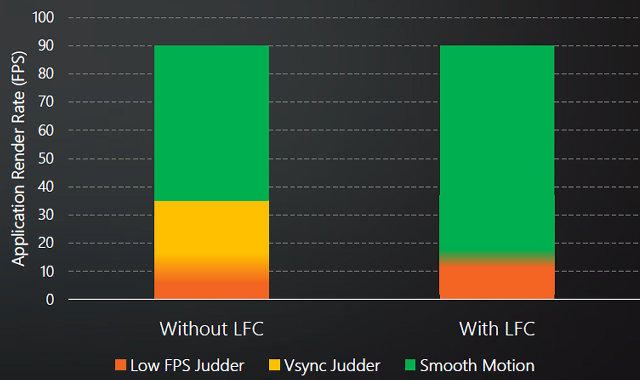

В недавнем обзоре нового видеодрайвера AMD Radeon Software Crimson Edition мы уже писали о технологии компенсации низкой частоты кадров Low Framerate Compensation (LFC), которая появилась в FreeSync начиная с этой версии драйверов. Работа LFC заключается в том, что технология постоянно отслеживает скорость рендеринга и вставляет дополнительные кадры, когда частота кадров падает ниже минимальной поддерживаемой частоты обновления дисплеем с поддержкой FreeSync.

Специальный адаптивный алгоритм автоматически изменяет последовательность выходных кадров и их частоту обновления так, чтобы снизить неприятные рывки из-за падения частоты кадров. При FPS ниже минимальной частоты обновления и включенной вертикальной синхронизации (VSync on) FreeSync ранее вовсе не работал, что вызывало неплавность в смене кадров. Но теперь, с включением LFC, смена кадров в таком случае плавная. При отключенной синхронизации в тех же условиях наблюдаются разрывы кадра (так называемый tearing), но включение LFC снижает и их.

Технология LFC работает исключительно программно и может быть модифицирована для будущих мониторов. В том числе поэтому никакой настройки со стороны пользователя или обновления монитора она не требует, эта возможность автоматически включается на всех мониторах с поддержкой FreeSync, максимальная частота обновления которых в 2,5 раза превосходит минимальную.

На приложенной диаграмме видно, что в конфигурации с монитором Asus MG279Q с его диапазоном частоты обновления 35—90 Гц без включения LFC рывки наблюдаются при частоте кадров менее 35 FPS, а при включении этой технологии FreeSync работает и при меньшей частоте, когда минимальная комфортная граница частоты кадров отодвигается вниз до 15 FPS.

В ноутбуке используется стандарт eDP (embedded DisplayPort) и прямое подключение ЖК-панели к графическому процессору без необходимости установки специальной платы scaler. К сожалению, описанная нами выше технология компенсации низкой частоты кадров LFC в случае ноутбука Lenovo работать не будет, так как разница между 40 и 60 Гц меньше 2,5 раз, что слишком мало для корректной работы этой возможности.

Очередным анонсом, связанным с FreeSync, является объявление о совместной работе компании AMD с производителями мониторов для обеспечения работы технологии FreeSync при HDMI-подключении, что на данный момент невозможно. Эта возможность важна потому, что разъемы HDMI распространены куда шире, чем DisplayPort, что даст пользователям более широкий выбор телевизоров и мониторов с поддержкой технологии динамического изменения частоты обновления.

Кстати, по мнению представителей AMD, сравнительно малое количество мониторов с разъемами DisplayPort объясняется в основном маркетинговыми причинами. Ведь порты HDMI значительно лучше известны по бытовым устройствам вроде телевизоров, плееров и проекторов, хотя за их использование производителям и приходится платить немалые отчисления.

AMD обещает открыть возможность работы FreeSync по HDMI в начале 2016 года, и эта возможность будет доступна для всех APU и GPU компании, которые поддерживают FreeSync по DisplayPort. Вероятно, это приведет к расширению предложения FreeSync-дисплеев на рынке, так как 70% массовых устройств не имеют поддержки разъема DisplayPort. Кроме этого, еще одной из полезных возможностей станет возможность подключения FreeSync-монитора к ноутбуку с видеокартой Radeon и разъемом HDMI на борту.

Компания полностью поддерживает будущую стандартизацию динамически изменяемых частот обновления в будущих версиях HDMI, но в AMD не хотят ждать окончания процесса стандартизации. Так как текущий стандарт HDMI имеет возможность включения специальных vendor-specific расширений, компания AMD воспользовались этим временным решением, чтобы внедрить технологию FreeSync в уже существующую версию этого стандарта. Важно, что их расширение полностью совместимо как с будущими моделями Radeon, так и с уже вышедшими устройствами, соответствующими стандарту HDMI.

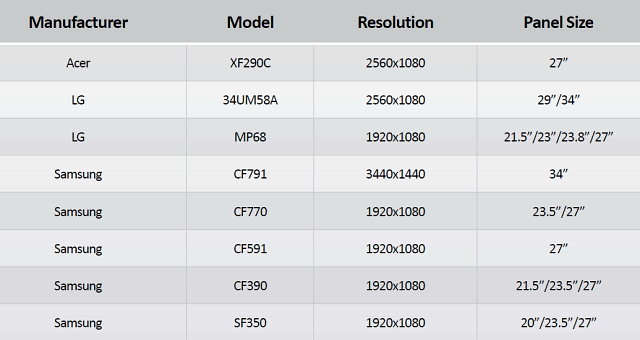

На данный момент компания работает со своими партнерами, в числе которых Acer, LG, Mstar, Novatek, Realtek, Samsung, для обеспечения работы обсуждаемой технологии динамического изменения частоты обновления в том числе и при помощи HDMI-портов. Приведем список первых мониторов с поддержкой работы FreeSync при HDMI-подключении — компаний Acer, LG и Samsung:

Как видите, мониторы готовятся разные, с размерами экрана от 20 до 34 дюймов и различным разрешением. Разве что типы устанавливаемых в них матриц пока что неизвестны.

Также поддержка работы технологии FreeSync с подключением по HDMI-разъемам будет обеспечиваться и будущими моделями ноутбуков, основанных на процессорах компании AMD: гибридных APU в сочетании с дискретными GPU, начиная с некоторых моделей, планируемых к выходу в первом квартале наступающего года.

Поддержка стандарта DisplayPort 1.3 в следующем поколении Radeon

Ну и последним, но от этого не менее важным анонсом сегодняшнего дня стало объявление о поддержке будущего стандарта вывода визуальной информации в следующем поколении графических процессоров компании AMD. Ожидаемые в следующем году видеокарты Radeon будут первыми в индустрии решениями с поддержкой DisplayPort 1.3. Новая версия этого стандарта использует существующие кабели и разъемы, разве что могут накладываться дополнительные ограничения на их длину.

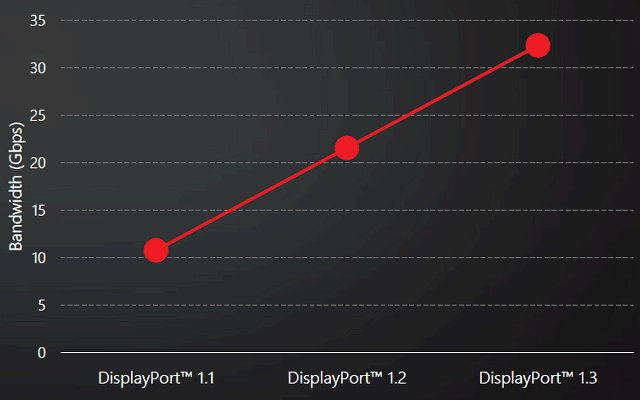

Вероятно, одними из первых графических решений Radeon следующего поколения будут мобильные GPU, которые и станут первенцами в поддержке стандарта DisplayPort 1.3 HBR3, окончательно выпущенного в сентябре 2014 года. Главным преимуществом нового стандарта является увеличение пропускной способности до 32,4 Гбит/с, что наконец-то отодвинет предел по пропускной способности, имеющийся в предыдущем поколении DisplayPort 1.2.

Это значение более чем на 80% превышает возможности HDMI 2.0 и позволяет подключить 5K-мониторы в RGB-формате при 60 Гц, используя единственный кабель (сейчас приходится подключать пару разъемов и кабелей, и такие мониторы являются как бы парой дисплеев), а также UHDTV-телевизоры с разрешением 8K (7680×4320), используя цветовую субдискретизацию 4:2:0 при 60 Гц. Также по DisplayPort 1.3 можно будет подключать и стереодисплеи (120 Гц) с 4K-разрешением.

Мониторы со сверхвысоким 5K-разрешением имеют заметно большее количество пикселей по сравнению с 4K-устройствами — их на 78% больше. Это дает плотность точек в 210 пикселей на дюйм для 5K-мониторов по сравнению с 142 ppi для 4K-дисплеев того же размера. Понятно, что в результате будет обеспечена куда большая четкость и большее пространство для приложений на рабочем столе. Появление 5K-дисплеев, рассчитанных на подключение одним кабелем DisplayPort 1.3, ожидается к середине 2016 года, а 4K-дисплеи с поддержкой HDR должны появиться уже в конце следующего года.

Также новый стандарт будет полезен для продвижения технологии FreeSync. Компания AMD ожидает появления первых устройств с 4K-разрешением с поддержкой технологии динамического обновления до 120 Гц в конце 2016 года. Такие мониторы будут способны работать в 4K-разрешении с применением технологий FreeSync и компенсации низкой частоты кадров Low Framerate Compensation в частности.

Вот список характеристик для мониторов нового поколения, которые становятся возможны при использовании новой версии стандарта DisplayPort 1.3 с расширенной пропускной способностью: мониторы с разрешением 1920×1080 пикселей: 240 Гц SDR и 240 Гц HDR; мониторы с разрешением 2560×1440: 240 Гц SDR и 170 Гц HDR; 4K-мониторы: 120 Гц SDR и 60 Гц HDR; 5K-мониторы: 60 Гц SDR. Пользователям остается лишь дождаться середины или конца 2016 года, заработав к тому времени достаточное количество денег для приобретения подобных устройств, которые явно будут стоить недешево.

Что такое G-Sync, FreeSync, V-Sync и HDMI VRR? — Разбор

Всех ПК-геймеров планеты Земля, да и консольных игроков тоже, объединяет одна проблема — вертикальные разрывы изображения. И вроде бы есть куча технологий которые решают эту проблему:

Давайте сегодня раз и навсегда разберемся в технологиях адаптивной синхронизации изображения.

Для тех кто не в курсе. А в чём собственно проблема?

Чтобы изображение появилось на экране, должно произойти, как минимум, две вещи:

Обычные мониторы работают на частоте 60 Гц, то есть способны выводить 60 кадров в секунду, а игровые на 144 Гц и выше.

А вот графический процессор живет в совершенно ином мире. В играх постоянно всё меняется: колышется листва, журчит ручеёк, враги выпрыгивают из-за угла. Каждый кадр отличается по своей сложности, поэтому на их просчет уходит разное количество времени.

Иными словами, у монитора частота кадров постоянная, а у видеокарты переменная.

Вот и выходит, что за один цикл обновления монитора видеокарта может подготовить больше одного кадра или меньше.

Из-за этого мало того что страдает плавность картинки, так еще и появляются артефакты в виде вертикальных разрывов изображения. Кстати, при просмотре фильмов тоже могут появляться такие артефакты, потому что кино снимают в 24 к/с.

V-Sync

Очевидно проблема требовала решения, и еще на заре компьютерных игр оно появилось! Название у этого решения — вертикальная синхронизация или V-Sync. Наверняка вы встречали такую опцию как в настройках видеокарты, так и в играх.

Работает эта штука достаточно топорно. Фактически она просто принуждает видеокарту выводить кадры с частотой кратной частоте обновления экрана. Например, если у вас монитор 60 Гц, то максимальное количество кадров в секунду тоже будет 60, даже если ваша видеокарта способна на большее. И в общем-то часто такое ограничение вполне уместно, если у видеокарты хватает мощи и нет просадок ниже 60 к/с, но если они есть — начинаются проблемы.

При включенной вертикальной синхронизации, следующее кратное значение — это 30 к/с. Поэтому даже если ваш фреймрейт просел фактически всего на пару кадров, вы всё равно увидите падение до 30 к/с. Такой перепад мало того, что большой и очень визуально ощутимый, так ещё и будет происходить с небольшим лагом. Поэтому если стабильного FPS в 60 к/с или 30 не достичь, то включать V-Sync вообще нет никакого смысла.

Справедливости ради, чем выше герцовка монитора, тем больше мы имеем кратных значений, на которых может работать синхронизация. Поэтому на игровых мониторах V-Sync работает куда лучше.

Но история с кратными значениями — не самая главная проблема технологии. Есть другой неочевидный недостаток: вертикальная синхронизация — увеличивает задержку ввода, то есть создаёт Input Lag.

Игра медленнее реагирует на ваши действия, всё происходит с задержками и как-то плывёт в молоке, поэтому прицелиться становится гораздо сложнее. Почему так происходит?

Это интересно, смотрите! Каждый кадр рассчитывается и выводится на экран через один и тот же конвейер. Упростим его до трёх этапов.

Ну и в чём проблема, спросите вы? Дело в том, что ЦП не берется за подготовку следующего кадра, пока предыдущий не будет выведен на экран. Поэтому ограничивая количество выводимых кадров в угоду синхронизации с дисплеем, мы фактически увеличиваем задержки с которыми обновляется состояние игры! И если в каких-то простеньких играх типа пасьянса такие вещи допустимы, то в соревновательных играх вертикальная синхронизация может стать серьёзной помехой.

G-Sync

Но переживать не стоит, так как решение появилось еще в 2013 году. Именно тогда компания NVIDIA представила свою технологию адаптивной синхронизации — G-Sync. В отличие от старой технологии, G-Sync позволяет подстраивать не видеокарту под частоту обновления монитора, а наоборот заставляет монитор менять свою частоту под видеокарту!

Представляете? Так тоже можно было!

В результате мы получаем потрясающе плавную картинку без вертикальных разрывов и задержки ввода! Просто сказка! G-Sync также работает в огромном диапазоне частот. Изначально это было от 30 до 144 Гц, а сейчас уже есть поддержка до 360 Гц и может даже выше, тут скорее всё зависит от монитора.

А если фреймрейт падает ниже 60 Гц G-Sync умеет дублировать пропущенные кадры.

Получаются сплошные плюсы и проблема решена еще в 2013 году? Так почему же мы до сих пор об этом говорим?

Ну как сказать. Во-первых, эта технология закрытая, соответственно, G-Sync работает только с карточками NVIDIA, но это пол беды.

Все волшебные функции G-Sync стали возможны благодаря специальному чипу, который необходимо встроить в монитор. Естественно, эти чипы производит тоже NVIDIA и стоят они недешево. Поэтому мониторы с поддержкой G-sync в среднем стоят на 250-300$ дороже и таких моделей очень мало. То есть получилась классная, и для 2013 года революционная технология, но не универсальная и дорогая.

VESA Adaptive Sync

Поэтому уже спустя год, в 2014, Ассоциация стандартизации Video Electronics Standards Association или VESA представила открытую технологию Adaptive Sync, которая умеет, в принципе, всё то же самое, что и G-Sync, но без дорогостоящих чипов и работает на частотах от 9 до 240 Гц! Неплохо да?

Но для внедрения технологии нужно, чтобы её поддержку внедрили в прошивку и драйвер монитора, драйвер видеокарты, операционной системы и в игры!

А также необходимо наличие DisplayPort версии не ниже 1.2a, так как технология стала частью именно Display Port. Как видите, чтобы технология взлетела, нужно было проделать много работы. И этой работой занималась компания AMD.

AMD FreeSync

В 2015 году AMD внедрили Adaptive Sync в драйвера своих видеокарт и назвали технологию FreeSync. Реализация от AMD быстро получила очень широкое распространение. Добавить поддержку FreeSync в монитор оказалось настолько дешево, что сейчас сложнее найти игровой монитор без этой фичи, чем с ней.

Но AMD не остановились на просто внедрении стандарта от VESA. Также они добавили поддержку HDMI, начиная с версии 1.4. А в 2017 выпустили FreeSync 2, в который добавилась поддержка HDR и компенсацию низкой частоты кадров, как в G-SYNC.

Кстати, чуть позже, FreeSync 2 переименовали в более элитное FreeSync Premium Pro, а обычный FreeSync для мониторов с частотой 120 Гц и выше стали называть FreeSync Premium. Хотя такие маркетинговые финты я не одобряю, но в остальном сплошной респект AMD за популяризацию стандарта.

Кстати, NVIDIA также в 2017 году добавила поддержку HDR и назвала это всё G-Sync Ultimate.

И вроде бы всё классно, в команде у красных и у зеленых есть по своей шикарной технологии. Но что делать, если у тебя видеокарта от NVIDIA, ты хочешь нормальную поддержку G-Sync, но покупать дорогущий монитор с этой технологией совсем не хочется? Или наоборот — не покупать же Radeon только потому что у тебя монитор с FreeSync?

G-Sync Compatible

Но в 2019 году NVIDIA пошли навстречу покупателям и добавили поддержку стандарта VESA Adaptive Sync в драйвера для своих видеокарт серии RTX, а также для карточки GTX 1080. А значит теперь можно легко насладиться лучшим из двух миров: взять себе карточку от NVIDIA и монитор с FreeSync по вкусу. Вот только есть проблема. Если на FreeSync мониторе не написано G-Sync Compatible — значит он не был протестирован NVIDIA на совместимость и никаких гарантий, что всё будет работать нормально, вам никто не даёт. А NVIDIA тестирует далеко не все, и далеко не самые доступные модели.

Поэтому инициативу по тестированию в свои руки взяло интернет-сообщество. Они составили табличку с огромным списком протестированных пользователями мониторов.

Причём всё будет работать и с видеокартами от NVIDIA и с Radeon. Всё потому, что VRR — это та же самая технология VESA Adaptive Sync, но теперь она стала ещё и частью стандарта HDMI 2.1. Именно таким образом адаптивная синхронизация реализована в консолях нового поколения. А также, вы удивитесь, в Xbox One S и One X. Да, в коробки текущего поколения от Microsoft VRR завезли даже раньше, чем HDMI 2.1.

Итоги

Что, в итоге спустя 6 лет после своего появления, технология Adaptive Sync стала фактически отраслевым стандартом. Захватив видеокарты от AMD и NVIDIA, телевизоры и даже интегрированная графика от Intel в 11-м поколении процессоров теперь поддерживает эту технологию. А это значит, что в светлом будущем мы будем жить без единого разрыва, по крайней мере, вертикального!